Python scrapy爬取蘇州二手房交易數據

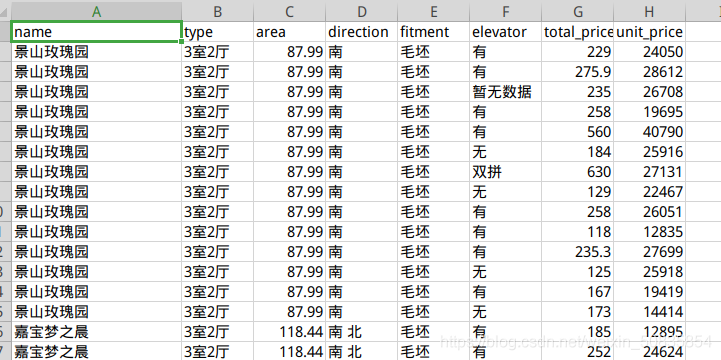

使用Scrapy爬取鏈家網中蘇州市二手房交易數據并保存于CSV文件中要求:房屋面積、總價和單價只需要具體的數字,不需要單位名稱。刪除字段不全的房屋數據,如有的房屋朝向會顯示“暫無數據”,應該剔除。保存到CSV文件中的數據,字段要按照如下順序排列:房屋名稱,房屋戶型,建筑面積,房屋朝向,裝修情況,有無電梯,房屋總價,房屋單價,房屋產權。

二、項目分析流程圖

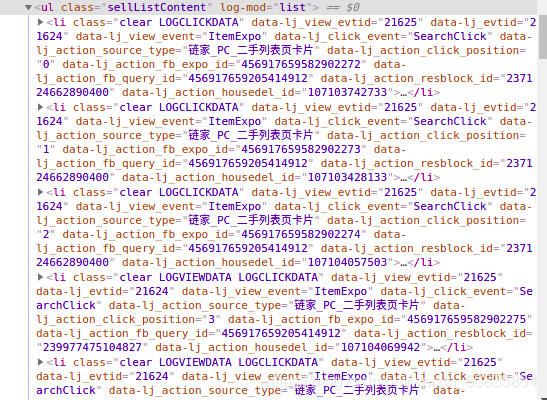

通過控制臺發現所有房屋信息都在一個ul中其中每一個li里存儲一個房屋的信息。

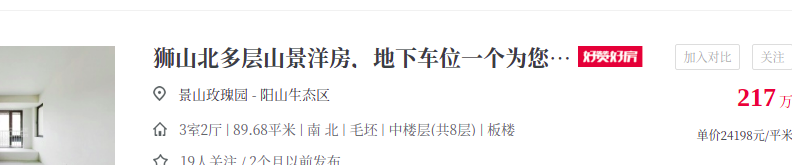

找了到需要的字段,這里以房屋名稱為例,博主用linux截圖,沒法對圖片進行標注,這一段就是最中間的“景山玫瑰園” 。其他字段類似不再一一列舉。獲取了需要的數據后發現沒有電梯的配備情況,所以需要到詳細頁也就是點擊標題后進入的頁面,點擊標題

可以看到里面有下需要的信息。

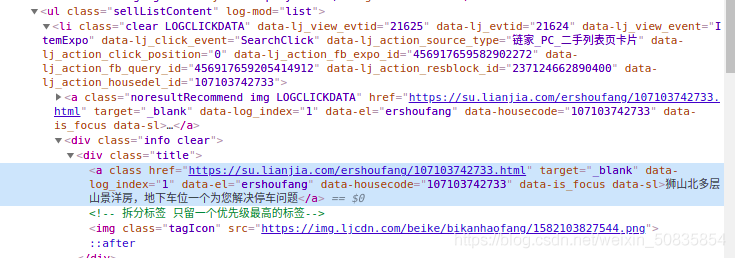

抓取詳細頁url

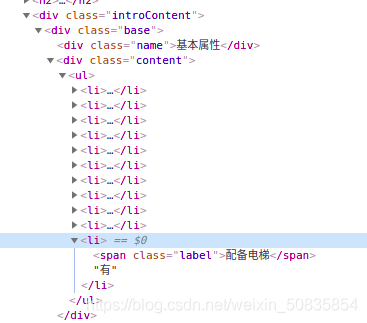

進行詳細頁數據分析

找到相應的位置,進行抓取數據。

三、編寫程序創建項目,不說了。

1.編寫item(數據存儲)

import scrapyclass LianjiaHomeItem(scrapy.Item): name = scrapy.Field() # 名稱 type = scrapy.Field() # 戶型 area = scrapy.Field() # 面積 direction = scrapy.Field() #朝向 fitment = scrapy.Field() # 裝修情況 elevator = scrapy.Field() # 有無電梯 total_price = scrapy.Field() # 總價 unit_price = scrapy.Field() # 單價

2.編寫spider(數據抓取)

from scrapy import Requestfrom scrapy.spiders import Spiderfrom lianjia_home.items import LianjiaHomeItemclass HomeSpider(Spider): name = 'home' current_page=1 #起始頁 def start_requests(self): #初始請求url='https://su.lianjia.com/ershoufang/'yield Request(url=url) def parse(self, response): #解析函數list_selctor=response.xpath('//li/div[@class=’info clear’]')for one_selector in list_selctor: try:#房屋名稱name=one_selector.xpath('//div[@class=’flood’]/div[@class=’positionInfo’]/a/text()').extract_first()#其他信息other=one_selector.xpath('//div[@class=’address’]/div[@class=’houseInfo’]/text()').extract_first()other_list=other.split('|')type=other_list[0].strip(' ')#戶型area = other_list[1].strip(' ') #面積direction=other_list[2].strip(' ') #朝向fitment=other_list[3].strip(' ') #裝修price_list=one_selector.xpath('div[@class=’priceInfo’]//span/text()')# 總價total_price=price_list[0].extract()# 單價unit_price=price_list[1].extract()item=LianjiaHomeItem()item['name']=name.strip(' ')item['type']=typeitem['area'] = areaitem['direction'] = directionitem['fitment'] = fitmentitem['total_price'] = total_priceitem['unit_price'] = unit_price #生成詳細頁url = one_selector.xpath('div[@class=’title’]/a/@href').extract_first()yield Request(url=url, meta={'item':item}, #把item作為數據v傳遞 callback=self.property_parse) #爬取詳細頁 except:print('error')#獲取下一頁 self.current_page+=1 if self.current_page<=100:next_url='https://su.lianjia.com/ershoufang/pg%d'%self.current_pageyield Request(url=next_url) def property_parse(self,response):#詳細頁#配備電梯elevator=response.xpath('//div[@class=’base’]/div[@class=’content’]/ul/li[last()]/text()').extract_first()item=response.meta['item']item['elevator']=elevatoryield item

3.編寫pipelines(數據處理)

import refrom scrapy.exceptions import DropItemclass LianjiaHomePipeline:#數據的清洗 def process_item(self, item, spider):#面積item['area']=re.findall('d+.?d*',item['area'])[0] #提取數字并存儲#單價item['unit_price'] = re.findall('d+.?d*', item['unit_price'])[0] #提取數字并存儲#如果有不完全的數據,則拋棄if item['direction'] =='暫無數據': raise DropItem('無數據,拋棄:%s'%item)return itemclass CSVPipeline(object): file=None index=0 #csv文件行數判斷 def open_spider(self,spider): #爬蟲開始前,打開csv文件self.file=open('home.csv','a',encoding='utf=8') def process_item(self, item, spider):#按要求存儲文件。if self.index ==0: column_name='name,type,area,direction,fitment,elevator,total_price,unit_pricen' self.file.write(column_name)#插入第一行的索引信息 self.index=1home_str=item['name']+','+item['type']+','+item['area']+','+item['direction']+','+item['fitment']+','+item['elevator']+','+item['total_price']+','+item['unit_price']+'n'self.file.write(home_str) #插入獲取的信息return item def close_soider(self,spider):#爬蟲結束后關閉csvself.file.close()

4.編寫settings(爬蟲設置)

這里只寫下需要修改的地方

USER_AGENT = ’Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.72 Safari/537.36’#為裝成瀏覽器ROBOTSTXT_OBEY = False #不遵循robots協議ITEM_PIPELINES = { ’lianjia_home.pipelines.LianjiaHomePipeline’: 300, #先進行數字提取 ’lianjia_home.pipelines.CSVPipeline’: 400 #在進行數據的儲存 #執行順序由后邊的數字決定}

這些內容在settings有些是默認關閉的,把用來注釋的 # 去掉即可開啟。

5.編寫start(代替命令行)

from scrapy import cmdlinecmdline.execute('scrapy crawl home' .split())

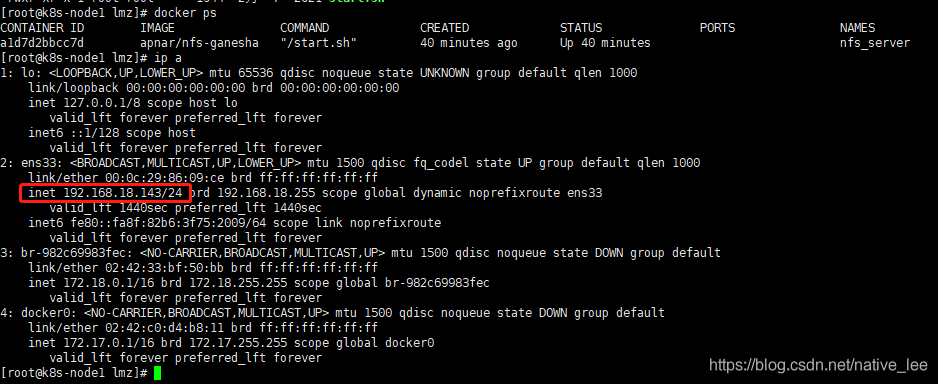

附上兩張結果圖。

此次項目新增了簡單的數據清洗,在整體的數據抓取上沒有增加新的難度。

到此這篇關于Python scrapy爬取蘇州二手房交易數據的文章就介紹到這了,更多相關scrapy爬取二手房交易數據內容請搜索好吧啦網以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持好吧啦網!

相關文章:

網公網安備

網公網安備