Python爬取網(wǎng)頁(yè)信息的示例

Python爬取網(wǎng)頁(yè)信息的步驟

以爬取英文名字網(wǎng)站(https://nameberry.com/)中每個(gè)名字的評(píng)論內(nèi)容,包括英文名,用戶名,評(píng)論的時(shí)間和評(píng)論的內(nèi)容為例。

1、確認(rèn)網(wǎng)址

在瀏覽器中輸入初始網(wǎng)址,逐層查找鏈接,直到找到需要獲取的內(nèi)容。

在打開的界面中,點(diǎn)擊鼠標(biāo)右鍵,在彈出的對(duì)話框中,選擇“檢查”,則在界面會(huì)顯示該網(wǎng)頁(yè)的源代碼,在具體內(nèi)容處點(diǎn)擊查找,可以定位到需要查找的內(nèi)容的源碼。

注意:代碼顯示的方式與瀏覽器有關(guān),有些瀏覽器不支持顯示源代碼功能(360瀏覽器,谷歌瀏覽器,火狐瀏覽器等是支持顯示源代碼功能)

步驟圖:

1)首頁(yè),獲取A~Z的頁(yè)面鏈接

2)名字鏈接頁(yè),獲取每個(gè)字母中的名字鏈接(存在翻頁(yè)情況)

3)名字內(nèi)容頁(yè),獲取每個(gè)名字的評(píng)論信息

2、編寫測(cè)試代碼

1)獲取A~Z鏈接,在爬取網(wǎng)頁(yè)信息時(shí),為了減少網(wǎng)頁(yè)的響應(yīng)時(shí)間,可以根據(jù)已知的信息,自動(dòng)生成對(duì)應(yīng)的鏈接,這里采取自動(dòng)生成A~Z之間的連接,以pandas的二維數(shù)組形式存儲(chǔ)

def get_url1(): urls=[] # A,’B’,’C’,’D’,’E’,’F’,’G’,’H’,’I’,’J’,’K’,’L’,’M’,’N’,’O’,’P’,’Q’,’R’,’S’,’T’,’U’,’V’,’W’,’X’,’Y’,’Z’ a=[’A’,’B’,’C’,’D’,’E’,’F’,’G’,’H’,’I’,’J’,’K’,’L’,’M’,’N’,’O’,’P’,’Q’,’R’,’S’,’T’,’U’,’V’,’W’,’X’,’Y’,’Z’]#自動(dòng)生成A~Z的鏈接 for i in a: urls.append('https://nameberry.com/search/baby_names_starting_with/%s' %i) dp=pd.DataFrame(urls) dp.to_csv('A~Z_Link1.csv',mode='a',encoding=’utf_8_sig’)#循環(huán)用于在每個(gè)字母鏈接下,調(diào)用爬取名字鏈接的頁(yè)面的函數(shù),即函數(shù)嵌套 for j in urls: get_pages_Html(j) return urls

2)獲取名字鏈接,根據(jù)網(wǎng)頁(yè)源碼分析出包含名字鏈接的標(biāo)簽,編寫代碼,名字鏈接用直接存儲(chǔ)的方式存儲(chǔ),方便讀取名字鏈接進(jìn)行對(duì)名字的評(píng)論內(nèi)容的獲取

#獲取頁(yè)數(shù)def get_pages_Html(url1): req = requests.get(url1) soup=BeautifulSoup(req.text)#異常處理,為解決頁(yè)面不存在多頁(yè)的問題,使用re正則表達(dá)式獲取頁(yè)面數(shù) try: lastpage = soup.find(class_='last').find('a')[’href’] str1=’{}’.format(lastpage) b=re.findall(’d+’, str1 ) for page in b: num=page except: num=1 get_pages(num,url1) return numdef get_pages(n,url): pages=[] for k in range(1,int(n)+1): pages.append('{}?page={}'.format(url,k)) dp=pd.DataFrame(pages) dp.to_csv('NUM_pages_1.csv',mode='a',encoding=’utf_8_sig’) #函數(shù)調(diào)用 for l in pages: parse_HTML2(l) return pages# 名字的鏈接,根據(jù)網(wǎng)頁(yè)源碼的標(biāo)簽,確定名字鏈接的位置def parse_HTML2(url2): try: req = requests.get(url2) req.encoding = req.apparent_encoding soup = BeautifulSoup(req.text) except: dp=pd.DataFrame(url2) dp.to_csv('Error_pages_1.csv',mode='a',encoding=’utf_8_sig’) name_data_l=[] error=[] li_list = soup.find_all(’li’,class_='Listing-name pt-15 pb-15 bdb-gray-light w-100pct flex border-highlight') try: for li in li_list: nameList=li.find(’a’,class_=’flex-1’)[’href’] name_data_l.append(’https://nameberry.com/’+nameList) time.sleep(1) cun(name_data_l,’Name_List_1’) except: dp=pd.DataFrame(name_data_l) dp.to_csv('Error_Name_List_1.csv',mode='a',encoding=’utf_8_sig’) # cun(url2,’Error_link_Q’) # dp=pd.DataFrame(name_data_l) # dp.to_csv('Name_List.csv',mode='a',encoding=’utf_8_sig’) # for i in name_data_l: # parse_HTML3(i) return name_data_l

3)獲取名字評(píng)論的內(nèi)容,采用字典形式寫入文件

# 名字里的內(nèi)容def parse_HTML3(url3): count=0 req = requests.get(url3) req.encoding = req.apparent_encoding soup = BeautifulSoup(req.text) error=[] try: Name=soup.find(’h1’,class_=’first-header’).find('a').get_text().replace(',','').replace('n','') except: error.append(url3) cun(error,'Error_Link_Comment') li_list = soup.find_all(’div’,class_='comment') for li in li_list: Title=li.find('h4').get_text().replace(',','').replace('n','') Time=li.find('p',class_=’meta’).get_text().replace(',','').replace('n','') Comments=li.find('div',class_=’comment-text’).get_text().replace(',','').replace('n','') dic2={ 'Name':Name, 'Title':Title, 'Time':Time, 'Comments':Comments } time.sleep(1) count=count+1 save_to_csv(dic2,'Name_data_comment') print(count) return 1

3、測(cè)試代碼

1)代碼編寫完成后,具體的函數(shù)調(diào)用邏輯,獲取鏈接時(shí),為直接的函數(shù)嵌套,獲取內(nèi)容時(shí),為從文件中讀取出名字鏈接,在獲取名字的評(píng)論內(nèi)容。避免因?yàn)橹饘釉L問,造成訪問網(wǎng)頁(yè)超時(shí),出現(xiàn)異常。

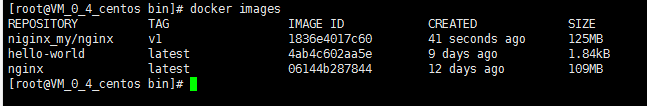

如圖:

2)測(cè)試結(jié)果

4、小結(jié)

在爬取網(wǎng)頁(yè)內(nèi)容時(shí),要先分析網(wǎng)頁(yè)源碼,再進(jìn)行編碼和調(diào)試,遵從爬蟲協(xié)議(嚴(yán)重者會(huì)被封號(hào)),在爬取的數(shù)據(jù)量非常大時(shí),可以設(shè)置順序部分請(qǐng)求(一部分的進(jìn)行爬取網(wǎng)頁(yè)內(nèi)容)。

總之,爬蟲有風(fēng)險(xiǎn),測(cè)試需謹(jǐn)慎!!!

以上就是Python爬取網(wǎng)頁(yè)信息的示例的詳細(xì)內(nèi)容,更多關(guān)于Python爬取網(wǎng)頁(yè)信息的資料請(qǐng)關(guān)注好吧啦網(wǎng)其它相關(guān)文章!

相關(guān)文章:

1. ASP實(shí)現(xiàn)加法驗(yàn)證碼2. 無線標(biāo)記語(yǔ)言(WML)基礎(chǔ)之WMLScript 基礎(chǔ)第1/2頁(yè)3. ASP刪除img標(biāo)簽的style屬性只保留src的正則函數(shù)4. PHP循環(huán)與分支知識(shí)點(diǎn)梳理5. ASP基礎(chǔ)入門第三篇(ASP腳本基礎(chǔ))6. 利用CSS3新特性創(chuàng)建透明邊框三角7. 解析原生JS getComputedStyle8. css代碼優(yōu)化的12個(gè)技巧9. 前端從瀏覽器的渲染到性能優(yōu)化10. 讀大數(shù)據(jù)量的XML文件的讀取問題

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備